8 JUN, 2021 • Achtergrond

Zo kan regulering van AI succes worden voor Nederlandse bedrijven

Wat willen we eigenlijk dat kunstmatige intelligentie (AI, Artificial Intelligence) kan? En wat mag het? Nu AI steeds meer verweven raakt in ons dagelijks leven – van gezichtsherkenning tot Netflix-aanbevelingen – is het tijd om regels te maken, vindt de Europese Commissie. Goede regels, die beschermen, maar ook ruimte laten voor ontwikkelen. Er ligt nu een voorstel. Hoe pakt dat uit voor ondernemers?

Transparantie bij AI is hard nodig

Vertrouwen en innovatie, dat zijn de twee kernpunten in het plan van de eurocommissarissen Margarete Verstager (Europe fit for the Digital Age) en Thierry Breton (Interne Markt). Aan dat vertrouwen ontbreekt het nu, met zorgen over de invloed die Facebook heeft tijdens bijvoorbeeld verkiezingen of coronaberichtgeving. En hoe bijvoorbeeld winkelplatforms als Amazon omgaan met data van gebruikers. En wat overheden eigenlijk allemaal mogen verzamelen en combineren.

‘On Artificial Intelligence, trust is a must’, zei Vestager bij de lancering van het voorstel. ‘Not a nice to have.‘ Daarom zijn er vier risiconiveaus aangewezen (zie kader). Is sprake van onacceptabel risico, dan is gebruik verboden. Bij hoog risico moet een uitgebreide set veiligheidsmaatregelen in acht worden genomen voor het is toegestaan. En AI-systemen met beperkt risico moeten transparant zijn, zodat consumenten kunnen kiezen om er geen gebruik van te maken. Tenslotte zijn er programma’s die zo simpel zijn, dat ze geen risico vormen. Die vallen buiten de AI-regelgeving van de EU.

Dat er regels komen voor AI is logisch. De AI-coalitie – een samenwerkingsverband van overheid, bedrijfsleven, onderwijs- en onderzoeksinstellingen en maatschappelijke organisaties – had daar in Nederland anderhalf jaar geleden al een voorzet voor gedaan op nationaal niveau. Het is ook goed voor het bedrijfsleven dat er een transparantieverplichting komt. Dat lijkt misschien raar, maar regelgeving en transparantie zijn goed voor innovatie. Het schept vertrouwen in de samenleving. En dat vertrouwen is weer nodig om een license to operate te hebben en dus ook gebruik te mogen/kunnen maken van AI. Een andere plus is dat regulering in combinatie met steun voor innovatie en toepassing van (gereguleerde) AI, de ontwikkeling van AI in de EU kunnen versterken. En dat is weer goed omdat de EU dan een vuist kan maken ten opzichte van bijvoorbeeld de VS of China als het eigen cruciale technologieën achter de hand heeft.

Zo zit de risicokwalificatie uit het voorstel van de Europese Commissie in elkaarUnacceptable risk – systemen die menselijk gedrag manipuleren om de vrije wil van gebruikers te omzeilen. Zoals spraakassistenten die gevaarlijk gedrag bij minderjarigen aanmoedigen. Of systemen die ‘sociale kredietsystemen’ door overheden mogelijk maken.

High risk – bijvoorbeeld technologie in kritische infrastructuur die het leven van mensen in gevaar kan brengen, in veiligheidsonderdelen van bijvoorbeeld robotchirurgen of technieken die deel uitmaken van een justitieel of democratisch proces.

Limited risk – bijvoorbeeld Chatbots

Minimal risk – videogames of spam filters

Ruimte voor innovatie bij AI is fijn en hard nodig

In het voorstel van Vestager en Breton zitten daarnaast twee heel mooie plannen voor het bedrijfsleven. Een zandbak (sand box) en ‘hubs’ waar bedrijven kennis en ervaringen kunnen uitwisselen. Want de EU wil kunstmatige intelligentie niet alleen maar reguleren, ze wil ook dat er op een veilige manier naar hartenlust geïnnoveerd kan worden. Als principe zijn de sand boxes, (‘zandbakken om in te spelen’) een heel goed middel. Een digitale ruimte zeg maar, waarin een AI-programma afgezonderd van andere systemen werkt. Zo kan er geen ‘kruisbesmetting’ van data plaatsvinden. Dat klinkt lekker veilig, maar er moet wel ruimte blijven om te experimenteren. En het is maar de vraag of dat echt kan. Zoals het Commissievoorstel nu luidt, lijken de sand boxes behoorlijk dicht gereguleerd. Dat maakt juist dat experimenteren moeilijk.

regelgeving en transparantie zijn goed voor innovatie

Wat het betekent om beperkt te worden in je bewegingsruimte bij experimenten heeft de financiële sector al sinds 2016 gemerkt, schrijft het Financieele Dagblad begin 2020. Toegelaten worden tot de sand box blijkt niet zo gemakkelijk, zeggen bedrijven tegen het FD. Omdat de regelgeving waaraan toezichthouders gebonden zijn helemaal niet is toegesneden op ‘ja’ zeggen, zijn vooruitstrevende experimenten vrijwel onmogelijk. Trajecten blijken duur en kosten veel tijd zonder dat het veel uithaalt. De toezichthouders op hun beurt vinden dat er wel erg veel ‘cowboys’ op de proeftuin af komen.

Toezichthouders spelen dus een belangrijke rol en zeker op Europese schaal zijn er daar veel van. Dat betekent: veel kapiteins op het schip. Denk in Nederland aan de Autoriteit Persoonsgegevens, de Market Surveillance Authority en de Autoriteit Financiële Markten. En in het voorstel van de Commissie, komt daar dan nog een AI Board bij die richtsnoeren kan uitvaardigen. Hoe moet je met zoveel pleinwachten nog kunnen ‘spelen’ in de zandbak?

Minstens zo interessant en belangrijk is de aangekondigde ontwikkeling van digital information hubs. Dat worden platforms waar Europese ondernemingen van elkaar kunnen leren (best practices) en in contact kunnen komen met bedrijven uit andere EU-landen. Zo moet kennis over kunstmatige intelligentie snel en laagdrempelig door het Europese bedrijfsleven worden gesluisd. Wat nog niet helemaal duidelijk is wie toegang krijgen tot deze hubs en wie ze gaat betalen. Het is wel belangrijk dat daar snel duidelijkheid over komt. Idealiter kunnen de kleintjes in contact komen met de r&d-afdeling van de grote bedrijven. Ook omdat de ‘kleintjes’ doorgaans leveranciers, afnemers of toekomstige overnamekandidaten zijn voor de grote spelers, en die zullen willen dat ook de kleintjes hun zaken op orde hebben.

moeten we de chinezen en amerikanen echt wijzer maken dan ze zijn over onze ai?

Maar… laat regelgeving niet knellen

Zijn we er nu? Is dit het plan dat de stelling ondersteunt: in China zijn de data van de overheid, in de VS van de bedrijven en in de EU van de burger? Niet helemaal. Het bedrijfsleven maakt zich zorgen over de bewegingsvrijheid die de Europese Commissie voor zichzelf heeft ingebouwd in bijvoorbeeld de risicoafweging. Op zich is het logisch om wat bewegingsruimte in te bouwen, omdat je nu niet weet welke ontwikkelingen er over vijf jaar zijn. Maar dat zou dan wel twee kanten op moeten werken. Dus niet alleen meer beperkingen kunnen opleggen, het zou ook mogelijk moeten zijn om bijvoorbeeld iets van de zogenoemde high risklijst af te halen. Dat kan in het voorstel van de Commissie niet. Dingen die we nu als risicovolle AI zien, worden misschien over vijf jaar niet eens meer als AI beschouwd. Ooit was het winnen van een partij schaak van de wereldkampioen schaken het toppunt van AI. IBM-supercomputer Deep Blue won in 1997 van Gary Kasparov, maar de techniek daarachter is nu niet erg bedreigend. Een goede schaakcomputer uit de winkel heeft in 2021 hetzelfde niveau.

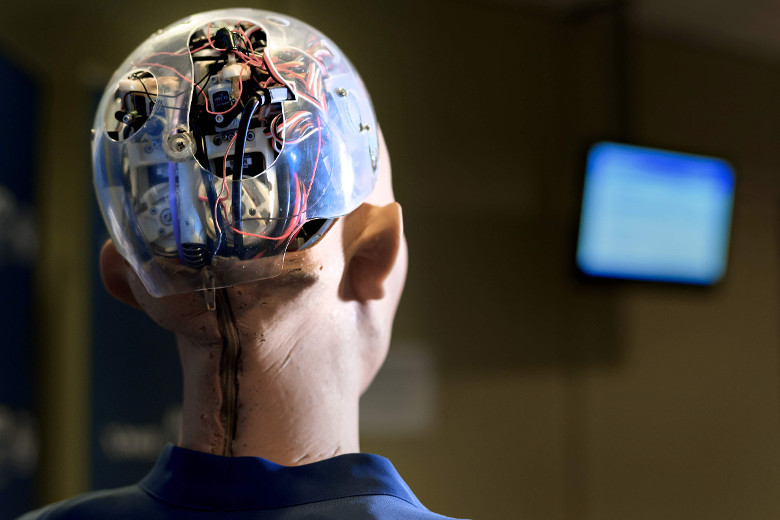

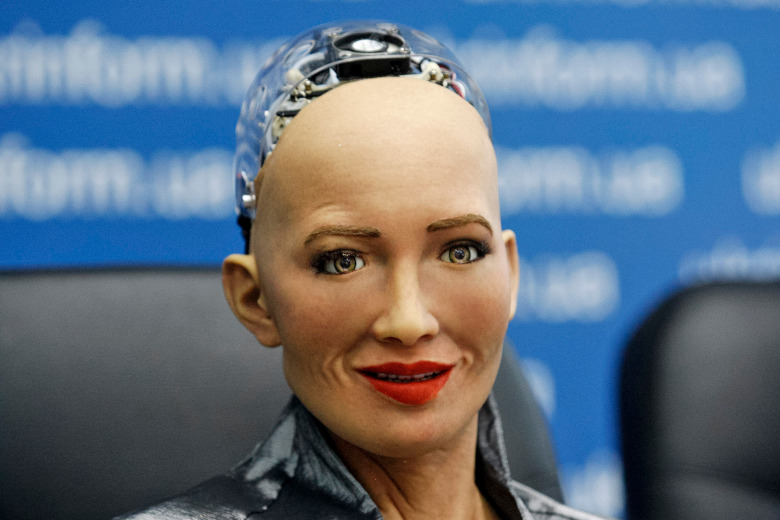

Kunstmatige intelligentie gaat onze levens onherkenbaar veranderen. Dat klinkt heel spannend en… dat is het dus ook. See for yourself

En wie bepaalt überhaupt wat high risk is en wat acceptable? De verwachting is dat de Commissie dat zal bepalen op basis van het advies van de nog in te stellen European AI Board. Zeker is dat niet. Ook niet wie er in de Board zitten. De toezichthouders, zeggen Verstager en Breton nu. Dat betekent dat de Board minstens uit 27 of misschien wel 54 leden bestaat, afhankelijk van de vraag of alle lidstaten één of twee toezichthouders hebben. En nemen dan de AI-experts of juristen die het naadje van de regelgevingskous kennen plaats in de Board? Want ook voor hen geldt: reguleren moet uitmonden in stimuleren, niet in frustreren.

Zorg dat het mkb ook mee kan doen

Voor grote multinationals zijn de voorstellen wel logisch inpasbaar. Zij zijn al jaren bezig met AI. Maar voor het mkb met bijvoorbeeld tien werknemers moeten de regels ook hanteerbaar zijn. Oók zij moeten aan die standaarden voldoen, maar zij zijn vaak niet zo ver met digitalisering en hebben niet voldoende mensen om dat te regelen. Het is belangrijk dat het eenvoudig wordt gemaakt om ook als mkb’er aan de regels te kunnen voldoen. Guidelines en templates zouden daarbij kunnen helpen, zodat voldoen aan de regels een simpele invuloefening wordt.

En tot slot: maak het de Chinezen en Amerikanen niet te gemakkelijk

De Commissie stelt nu voor om broncodes van AI openbaar te maken. De idee is dat zo manipulatieve codes snel worden ontdekt, maar het belangrijkste is wel dat een openbare broncode bewijst dat je niets te verbergen hebt. Goed voor het vertrouwen van de samenleving in AI dus. Daar plaatst het bedrijfsleven wel wat vraagtekens bij. Aan de ene kant is het de vraag of die code wel te begrijpen is voor anderen dan absolute experts. En aan de andere kant geef je hiermee een kijkje in de keuken en kun je bijvoorbeeld concurrenten uit China of de VS wijzer maken dan ze al zijn. Moeten we dat echt willen?

Op de hoogte blijven van onze beste artikelen? Schrijf je dan gratis in voor onze nieuwsbrief.

Wat is AI en welke vormen zijn er?Soms wordt weleens half-schertsend gezegd: ‘Kunstmatige intelligentie is wat we de computer nog niet kunnen laten doen’. Simpel gezegd is kunstmatige intelligentie (Artificial Intelligence, AI) een systeem of machine die menselijke intelligentie nabootst om taken uit te voeren en die zichzelf tijdens dat proces kan verbeteren op basis van de vergaarde informatie. Kunstmatige intelligentie begint in het dagelijks leven bij spamfilters en de aanbevelingen bij bedrijven als Bol.com en Netflix. Deze vormen van kunstmatige intelligentie zijn er te onderscheiden:

Rule-based kunstmatige intelligentie is een klassieke vorm en gebaseerd op geprogrammeerde ‘als dit, dan dat’-instructies. Zo’n systeem leert zichzelf niet, maar vertoont wel intelligent gedrag door een analyse te maken van de omgeving en hier acties op te ondernemen.

Supervised learning is gebaseerd op het docent-leerling model. De gebruiker is de docent en de software is de leerling die leert aan de hand van de feedback van de gebruiker. De computer krijgt verschillende voorbeelden te zien en de gebruiker legt uit wat het is. Een spamfiter werkt zo.

Reenforment learning heeft ook een leraar, maar anders dan bij supervised learning, krijgt de machine alleen te horen of zijn antwoord goed of fout is. De computer moet dus eerst zelf antwoord geven. Is het goed? Dan krijgt de machine pluspunten. Is het fout? Dan krijgt het minpunten. Zo leert het systeem op basis van trial & error zichzelf verbeteringen aan.

Unsupervised learning heeft geen leraar. In tegenstelling tot de andere vormen wordt de computer gevoed met data, maar de uitkomsten worden niet expliciet onderverdeeld in ‘goed of fout’. De machine moet zelf nadenken, clusteren en uitkomsten vormen, waarbij de antwoorden dus niet vastliggen. ‘Als iemand deze film kijkt, welke kiest iemand dan vaak nog meer?’. Tegen creditcardfraude wordt een variant gebruikt die zoekt naar patronen en afwijkingen daarop.

Handig: de wekelijkse Forum-alert

Handig: de wekelijkse Forum-alert